Nvidia je objavila da je njen predstojeći H100 „Hopper“ Tensor Core GPU postavio nove rekorde performansi tokom svog debija u industrijskim standardima MLPerf benchmark-a, isporučujući rezultate do 4,5 puta brže od A100, koji je trenutno Nvidijin najbrži produkcijski AI čip.

MPerf testovi (tehnički nazvan „MLPerfTM Inference 2.1“) mere radno opterećenje u procesima „zaključivanja“ (proizvodnje izlaznih podataka na osnovu ponuđenih ulaznih podataka), koje pokazuje koliko dobro čip može da primeni prethodno obučeni model mašinskog učenja na nove podatke. Grupa industrijskih firmi poznatih kao MLCommons razvila je MLPerf testove 2018. godine kako bi isporučila standardizovanu metriku za poređenje performansi u sistemima mašinskog učenja.

Konkretno, H100 se dobro pokazao u BERT-Large testu, koji meri performanse obrade prirodnog jezika koristeći BERT model koji je razvio Google. Nvidia ovaj konkretan rezultat pripisuje Transformer Engine-u Hopper arhitekture, koji ubrzava modele transformatora tokom obuke. To znači da bi H100 mogao da ubrza buduće modele prirodnog jezika slične OpenAI-jevom GPT-3, koji može da komponuje pisana dela u mnogo različitih stilova i da vodi razgovore.

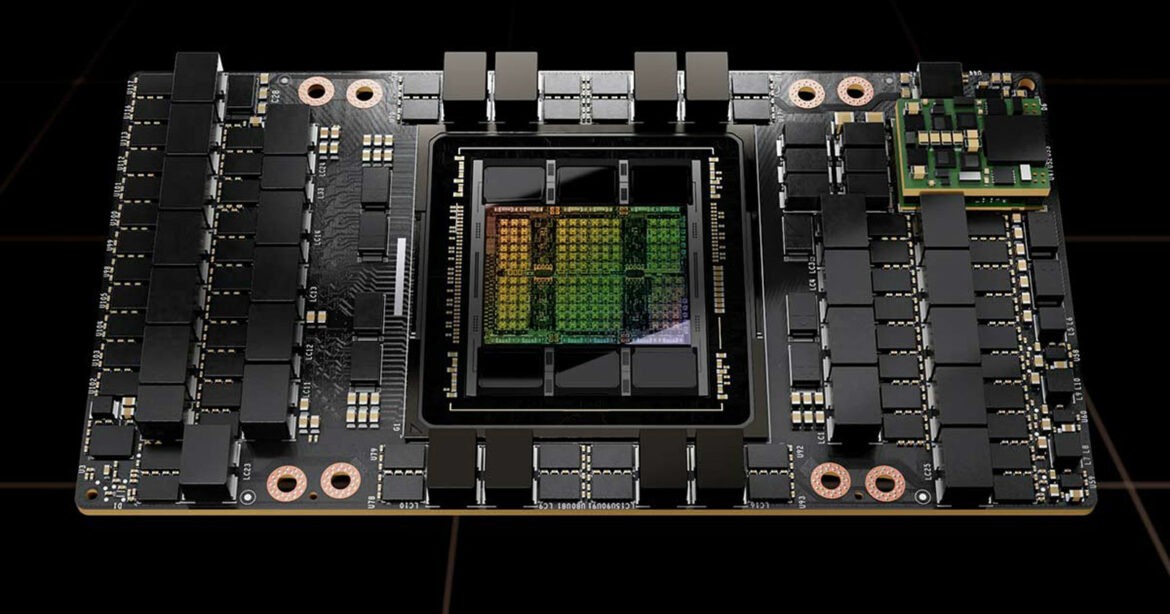

Nvidia pozicionira H100 kao vrhunski GPU čip za data centar dizajniran za AI i superkompjuterske aplikacije kao što su prepoznavanje slika, veliki jezički modeli, sinteza slika i još mnogo toga. Analitičari očekuju da će H100 zameniti A100 kao Nvidijin vodeći GPU za data centar, mada je još uvek u razvoju. Restrikcije američke vlade nametnute prošle nedelje na izvoz čipova u Kinu dovele su do bojazni da Nvidia možda neće moći da isporuči H100 do kraja 2022, pošto se deo njenog razvoja tamo odvija.