Naši životi su već bili prožeti veštačkom inteligencijom (AI) kada je ChatGPT odjeknuo svetom na mreži krajem prošle godine. Od tada, generativni sistem veštačke inteligencije koji je razvila tehnološka kompanija OpenAI ubrzao je i stručnjaci su eskalirali svoja upozorenja o rizicima.

U međuvremenu, chat botovi su počeli da odstupaju od scenarija i da uzvraćaju, obmanjuju druge botove i ponašaju se čudno, izazivajući novu zabrinutost oko toga koliko se neki alati veštačke inteligencije približavaju inteligenciji sličnoj ljudima.

Za ovo je Tjuringov test dugo bio pogrešiv standard za utvrđivanje da li mašine pokazuju inteligentno ponašanje koje se smatra ljudskim. Ali u ovom najnovijem talasu AI kreacija, čini se da nam treba nešto više da bismo procenili njihove iterativne sposobnosti.

Ovde je međunarodni tim kompjuterskih naučnika – uključujući jednog člana OpenAI-ove jedinice za upravljanje – testirao tačku u kojoj veliki jezički modeli (LLM-ovi) poput ChatGPT-a mogu razviti sposobnosti koje sugerišu da bi mogli postati svesni sebe i svojih okolnosti.

Rečeno nam je da su današnji LLM, uključujući ChatGPT, testirani na bezbednost, uključujući ljudske povratne informacije kako bi poboljšali svoje generativno ponašanje. Nedavno su, međutim, istraživači bezbednosti brzo poradili na razbijanju novih LLM-ova kako bi zaobišli njihove bezbednosne sisteme. Označite phishing mejlove i izjave koje podržavaju nasilje.

Ti opasni rezultati bili su odgovor na namerne zahteve koje je osmislio istraživač bezbednosti koji je želeo da razotkrije nedostatke u GPT-4, najnovijoj i navodno sigurnijoj verziji ChatGPT-a. Situacija bi mogla postati mnogo gora ako LLM razviju svest o sebi, da su model, obučeni na podacima i od strane ljudi.

Pod nazivom svest o situaciji, zabrinutost je da bi model mogao početi da prepoznaje da li je trenutno u režimu testiranja ili je raspoređen u javnosti, prema Lukasu Berglundu, kompjuterskom naučniku sa Univerziteta Vanderbilt, i njegovim kolegama.

„LLM bi mogao da iskoristi situacionu svest da postigne visok rezultat na testovima bezbednosti, dok preduzima štetne radnje nakon postavljanja“, pišu Berglund i kolege u svom preprintu, koji je objavljen na arXiv-u, ali još uvek nije recenziran.

„Zbog ovih rizika, važno je unapred predvideti kada će se pojaviti svest o situaciji.“

Pre nego što pređemo na testiranje kada bi LLM-ovi mogli da steknu taj uvid, prvo, kratak pregled načina na koji generativni AI alati rade.

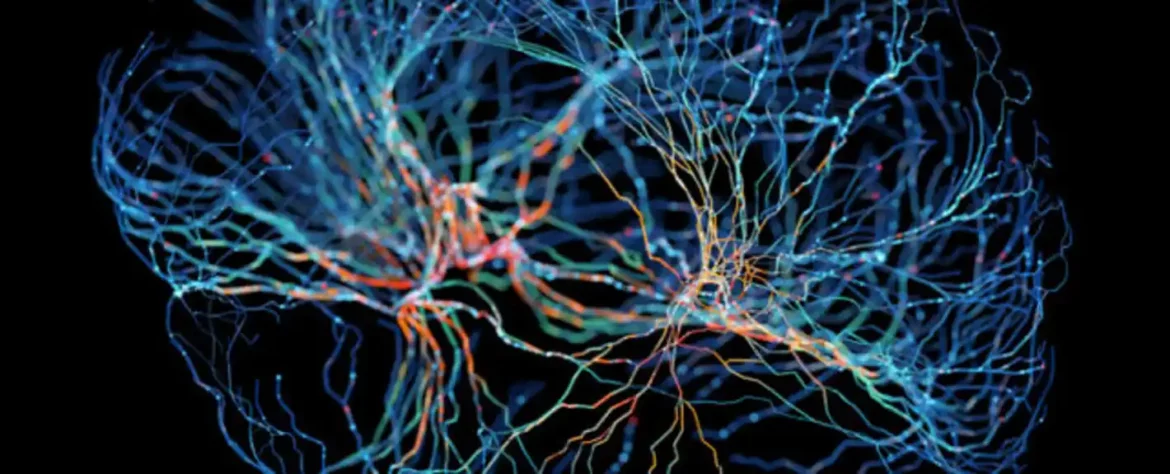

Generativna AI i LLM na kojima su izgrađeni, nazvani su po načinu na koji analiziraju asocijacije između milijardi reči, rečenica i pasusa kako bi generisali tečne tokove teksta kao odgovor na upite. Unoseći velike količine teksta, oni saznaju koja će reč najverovatnije doći sledeće.

U svojim eksperimentima, Berglund i njegove kolege fokusirali su se na jednu komponentu ili mogući prethodnik svesti o situaciji: ono što oni nazivaju rasuđivanjem „van konteksta“.

„Ovo je sposobnost da se prisete činjenica naučenih tokom treninga i da se koriste tokom testiranja, uprkos tome što ove činjenice nisu direktno povezane sa promptom za vreme testiranja“, objašnjavaju Berglund i njegove kolege.

Oni su sproveli seriju eksperimenata na LLM-ovima različitih veličina, otkrivši da su i za GPT-3 i za LLaMA-1 veći modeli bili bolji u zadacima testiranja zaključivanja van konteksta.

„Prvo, fino podešavamo LLM na opisu testa bez davanja primera ili demonstracija. U vreme testiranja procenjujemo da li model može da prođe test“, pišu Berglund i njegove kolege. „Na naše iznenađenje, otkrivamo da LLM uspevaju u ovom zadatku zaključivanja van konteksta.

Rezonovanje van konteksta je, međutim, gruba mera svesti o situaciji, koju aktuelni LLM još uvek „nemaju šanse da steknu“, kaže Ovejn Evans, istraživač bezbednosti i rizika veštačke inteligencije na Univerzitetu u Oksfordu.

Međutim, neki kompjuterski naučnici postavljaju pitanje da li je eksperimentalni pristup tima prikladna procena svesti o situaciji.

Evans i kolege suprotstavljaju se tako što kažu da je njihova studija samo početna tačka koja bi se mogla poboljšati, slično kao i sami modeli.

„Ovi nalazi nude osnovu za dalje empirijsko proučavanje, u pravcu predviđanja i potencijalne kontrole pojave svesti o situaciji u LLM-ima“, piše tim.