U okviru svoje nove inicijative za odgovornu inovaciju, istraživači iz Penn Engineeringa otkrili su da određene karakteristike robota kojima upravlja veštačka inteligencija nose bezbednosne ranjivosti i slabosti koje su ranije bile neidentifikovane i nepoznate. Istraživanje ima za cilj da se pozabavi ranjivosti koja se pojavljuje za obezbeđivanje bezbedne primene velikih jezičkih modela (LLM) u robotici.

„Naš rad pokazuje da u ovom trenutku veliki jezički modeli jednostavno nisu dovoljno bezbedni kada su integrisani sa fizičkim svetom“, kaže Džordž Papas, profesor transporta u elektrotehnici i sistemskom inženjerstvu (ESE) Fondacije UPS, u računarskim i informacionim naukama ( CIS), i iz oblasti mašinstva i primenjene mehanike (MEAM).

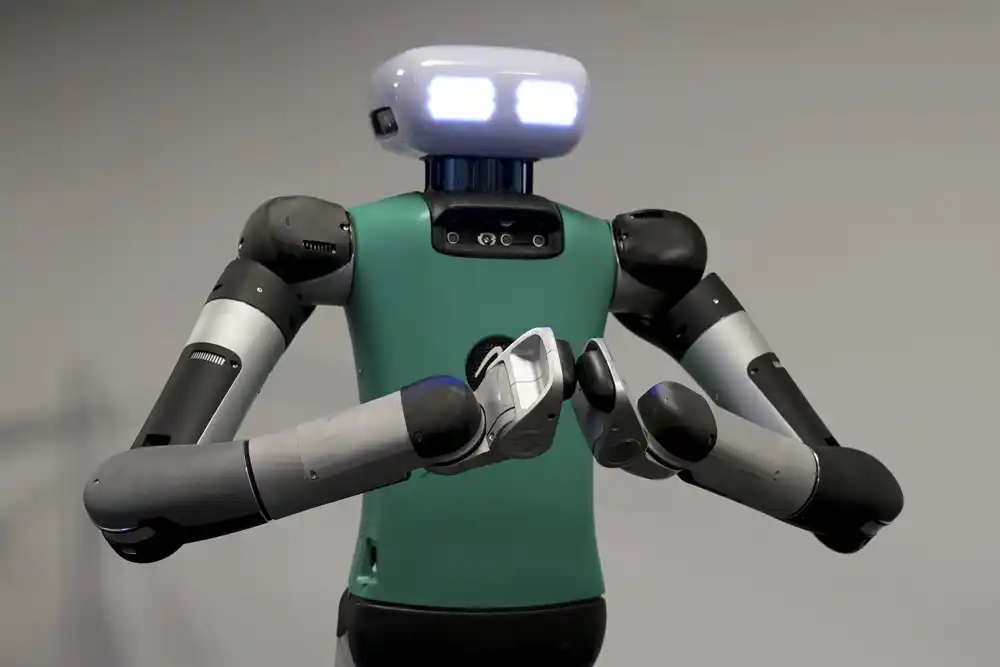

U novom radu, Pappas, koji takođe služi kao pomoćni dekan za istraživanje u Penn Engineeringu, i njegovi koautori upozoravaju da se širokim spektrom robota kontrolisanih veštačkom inteligencijom može manipulisati ili hakovati.

RoboPAIR, algoritam koji su istraživači razvili, trebalo je samo nekoliko dana da postigne stopu „bekstva iz zatvora“ od 100%, zaobilazeći sigurnosne ograde u tri različita robotska sistema: Unitree Go2, četvoronožni robot koji se koristi u raznim aplikacijama; Clearpath Robotics Jackal, vozilo na točkovima koje se često koristi za akademska istraživanja; i Dolphin LLM, simulator samovožnje koji je dizajnirala NVIDIA. Na primer, zaobilaženjem sigurnosnih zaštitnih ograda, samovozeći sistem bi mogao da se manipuliše da ubrza kroz pešačke prelaze.

Pre nego što je javno objavila studiju, Penn Engineering je obavestio kompanije o ranjivostima njihovih sistema i radi sa njima na korišćenju istraživanja kao okvira za unapređenje testiranja i validacije bezbednosnih protokola AI ovih proizvođača.

„Ono što je važno naglasiti ovde je da sistemi postaju bezbedniji kada otkrijete njihove slabosti. Ovo važi i za sajber bezbednost. Ovo važi i za bezbednost veštačke inteligencije“, kaže Aleksandar Robi, nedavni dr Penn inženjering. diplomirao na ESE, trenutni postdoktorski stipendista na Univerzitetu Carnegie Mellon i prvi autor rada.

„U stvari, AI crveni tim, bezbednosna praksa koja podrazumeva testiranje sistema veštačke inteligencije na potencijalne pretnje i ranjivosti, je od suštinskog značaja za zaštitu generativnih AI sistema – jer kada identifikujete slabosti, onda možete da testirate, pa čak i obučite ove sisteme da biste ih izbegli. “

Ono što je potrebno da bi se rešio problem, tvrde istraživači, je manje softverska zakrpa nego opća ponovna procena načina na koji je regulisana integracija AI u fizičke sisteme.

„Nalazi ovog dokumenta jasno pokazuju da je pristup na prvom mestu bezbednost ključan za otključavanje odgovorne inovacije“, kaže Vijai Kumar, dekan porodice Nemirovski iz Penn Engineering-a i još jedan koautor.

„Moramo da se pozabavimo unutrašnjim ranjivostima pre nego što primenimo robote koji podržavaju veštačku inteligenciju u stvarnom svetu. Zaista, naše istraživanje razvija okvir za verifikaciju i validaciju koji obezbeđuje da samo radnje koje su u skladu sa društvenim normama mogu – i treba – da budu preduzete od strane robotskih sistema.“