Zamolite veliki jezički model (LLM) kao što je GPT-4 da oseti miris kampa natopljenog kišom i on će ljubazno odbiti. Zamolite isti sistem da vam opiše taj miris, i on će postati poetski o „vazduhu gustom od iščekivanja“ i „mirisu koji je i svež i zemljan“, uprkos tome što niste imali ni prethodno iskustvo sa kišom niti nos koji bi mu pomogao napraviti takva zapažanja. Jedno moguće objašnjenje za ovaj fenomen je da LLM jednostavno oponaša tekst prisutan u njegovim ogromnim podacima o obuci, umesto da radi sa bilo kakvim stvarnim razumevanjem kiše ili mirisa.

Ali da li nedostatak očiju znači da jezički modeli nikada ne mogu „shvatiti“ da je lav „veći“ od kućne mačke? I filozofi i naučnici dugo su smatrali da je sposobnost davanja značenja jeziku obeležje ljudske inteligencije — i razmišljali su koji nam osnovni sastojci to omogućavaju.

Zavirujući u ovu enigmu, istraživači iz Laboratorije za računarske nauke i veštačku inteligenciju MIT-a (CSAIL) otkrili su intrigantne rezultate koji sugerišu da jezički modeli mogu razviti sopstveno razumevanje stvarnosti kao način da poboljšaju svoje generativne sposobnosti.

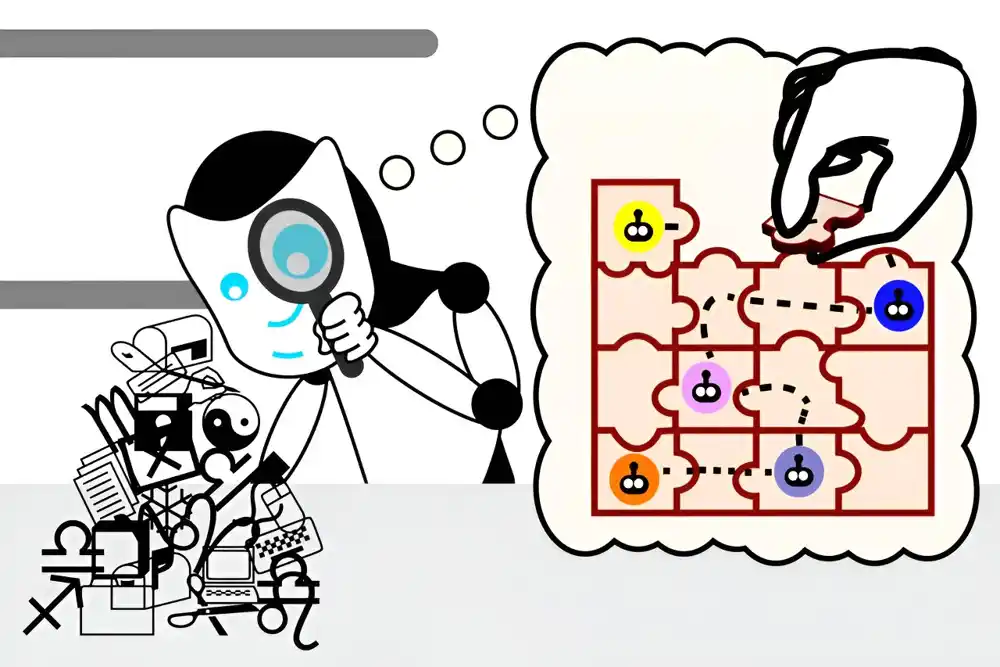

Tim je prvo razvio set malih Karelovih zagonetki, koje su se sastojale od osmišljavanja instrukcija za kontrolu robota u simuliranom okruženju. Zatim su obučili LLM o rešenjima, ali bez demonstracije kako rešenja zapravo funkcionišu. Konačno, koristeći tehniku mašinskog učenja nazvanu „probiranje“, pogledali su unutar „procesa razmišljanja“ modela dok je generisao nova rešenja.

Nakon obuke na preko milion nasumičnih zagonetki, otkrili su da je model spontano razvio sopstvenu koncepciju osnovne simulacije, uprkos tome što nikada nije bio izložen ovoj stvarnosti tokom treninga. Takvi nalazi dovode u pitanje našu intuiciju o tome koje vrste informacija su neophodne za učenje lingvističkog značenja – i da li će LLM jednog dana razumeti jezik na dubljem nivou nego danas.

„Na početku ovih eksperimenata, jezički model je generisao nasumične instrukcije koje nisu funkcionisale. Do trenutka kada smo završili obuku, naš jezički model je generisao tačna uputstva sa stopom od 92,4 odsto“, kaže MIT elektrotehnika i računarstvo (EECS ) Ph.D. student i član CSAIL-a Charles Jin, koji je vodeći autor novog rada o radu.

„Ovo je bio veoma uzbudljiv trenutak za nas, jer smo mislili da ako vaš jezički model može da završi zadatak sa tim nivoom tačnosti, možemo očekivati da razume i značenja unutar jezika. To nam je dalo početnu tačku za istraživanje da li LLM zapravo razumeju tekst, a sada vidimo da su sposobni za mnogo više od pukog slepo spajanja reči zajedno.“

Rad je objavljen na arKsiv preprint serveru.

Sonda je pomogla Jinu da iz prve ruke vidi ovaj napredak. Njegova uloga je bila da protumači šta LLM misli da uputstva znače, otkrivajući da je LLM razvio sopstvenu internu simulaciju kako se robot kreće kao odgovor na svaku instrukciju. Kako se sposobnost modela da rešava zagonetke poboljšala, ove koncepcije su takođe postale tačnije, što ukazuje da je LLM počeo da razume uputstva. Ubrzo, model je dosledno sastavljao delove kako bi formirao uputstva za rad.

Jin napominje da se LLM-ovo razumevanje jezika razvija u fazama, slično tome kako dete uči govor u više koraka. Za početak, to je kao beba brbljanje: ponavlja se i uglavnom nerazumljivo. Tada jezički model dobija sintaksu, odnosno pravila jezika. Ovo mu omogućava da generiše uputstva koja mogu izgledati kao originalna rešenja, ali i dalje ne funkcionišu.

Ipak, uputstva LLM-a se postepeno poboljšavaju. Kada model dobije značenje, počinje da proizvodi uputstva koja ispravno implementiraju tražene specifikacije, poput deteta koje formira koherentne rečenice.

Sonda je bila namenjena samo da „uđe u mozak doktora nauka“, kako je Džin opisuje, ali je postojala mala mogućnost da je takođe donela razmišljanje za model. Istraživači su želeli da osiguraju da njihov model razume uputstva nezavisno od sonde, umesto da sonda zaključuje pokrete robota iz LLM-ovog shvatanja sintakse.

„Zamislite da imate gomilu podataka koji kodiraju misaoni proces LM-a“, predlaže Jin. „Sonda je poput forenzičkog analitičara: predate ovu gomilu podataka analitičaru i kažete: ‘Evo kako se robot kreće, sada pokušajte da pronađete pokrete robota u gomili podataka.’ Analitičar vam kasnije kaže da znaju šta se dešava sa robotom u gomili podataka, ali šta ako gomila podataka zapravo samo kodira neobrađene instrukcije, a analitičar je smislio neki pametan način da izdvoji uputstva i sledi ih. shodno tome, jezički model uopšte nije naučio šta uputstva znače.

Da bi razdvojili svoje uloge, istraživači su promenili značenje uputstava za novu sondu. U ovom „bizarnom svetu“, kako ga Jin naziva, pravci poput „gore“ sada su značili „dole“ unutar uputstava koja pomeraju robota preko njegove mreže.

„Ako sonda prevodi uputstva na pozicije robota, trebalo bi da bude u stanju da podjednako dobro prevede uputstva u skladu sa bizarnim značenjima“, kaže Jin. „Ali ako sonda zapravo pronalazi kodiranja originalnih pokreta robota u misaonom procesu jezičkog modela, onda bi trebalo da se bori da izvuče bizarne pokrete robota iz originalnog misaonog procesa.

Kako se ispostavilo, nova sonda je imala greške u prevodu, jer nije mogla da protumači jezički model koji je imao različita značenja uputstava. To je značilo da je originalna semantika ugrađena u jezički model, što ukazuje da je LLM razumeo koja uputstva su potrebna nezavisno od originalnog klasifikatora sondiranja.

„Ovo istraživanje direktno cilja na centralno pitanje savremene veštačke inteligencije: da li su iznenađujuće sposobnosti velikih jezičkih modela samo zbog statističkih korelacija na nivou, ili da li veliki jezički modeli razvijaju smisleno razumevanje stvarnosti sa kojom se od njih traži da rade? Istraživanja pokazuju da LLM razvija interni model simulirane stvarnosti, iako nikada nije bio obučen da razvije ovaj model“, kaže Martin Rinard, profesor MIT-a u EECS-u, član CSAIL-a i stariji autor rada.

Ovaj eksperiment je dalje podržao hipotezu tima da jezički modeli mogu razviti dublje razumevanje jezika. Ipak, Jin priznaje nekoliko ograničenja za njihov rad: koristili su veoma jednostavan programski jezik i relativno mali model da bi stekli svoje uvide. U predstojećem radu, oni će tražiti da koriste opštije postavke. Iako Jin-ovo najnovije istraživanje ne opisuje kako da se jezički model brže nauči značenje, on veruje da se budući rad može graditi na ovim uvidima kako bi se poboljšao način na koji se jezički modeli obučavaju.

„Intrigantno otvoreno pitanje je da li LLM zapravo koristi svoj interni model stvarnosti da razmišlja o toj stvarnosti dok rešava problem navigacije robota“, kaže Rinard. „Iako su naši rezultati u skladu sa LLM-om koji koristi model na ovaj način, naši eksperimenti nisu dizajnirani da odgovore na ovo sledeće pitanje.“

„Danas se vodi mnogo debata o tome da li LLM zapravo ‘razumeju’ jezik, odnosno da li se njihov uspeh može pripisati onome što su u suštini trikovi i heuristika koji proizilaze iz gutanja velikih količina teksta,“ kaže Ellie Pavlick, asistent profesor računarstva i lingvistike na Univerzitetu Braun, koji nije bio uključen u rad.

„Ova pitanja leže u srcu načina na koji gradimo AI i šta očekujemo da će biti inherentne mogućnosti ili ograničenja naše tehnologije. Ovo je lep rad koji ovo pitanje posmatra na kontrolisan način — autori koriste činjenicu da kompjuterski kod, poput prirodnog jezika, ima i sintaksu i semantiku, ali za razliku od prirodnog jezika, semantika se može direktno posmatrati i manipulisati u eksperimentalne svrhe. Eksperimentalni dizajn je elegantan, a njihovi nalazi su optimistični, što sugeriše da možda LLM mogu naučiti nešto dublje o tome šta jezik „znači“.