Inženjeri kompanije Google su na AI Blog-u platforme prošle nedelje objavili rezultate rada na novom jezičkom modelu. Model koristi principe koje je unapredio PaLM model (eng. Pathways Language Model, baziran na prethodno razvijenoj AI Pathways arhitekturi) i demonistrira ispravno i uspešno rezonovanje o problemima koji su zapisani prirodnim jezikom.

Ukoliko želite da se istražite primere koje je model rešavao, to možete uradi ovde: https://minerva-demo.github.io/.

Primer zadatka koji je model sposoban da reši:

Pitanje: Linija koja je paralelna pravoj y = 4x + 6 prolazi kroz tačku (5, 10). Koliko iznosi y koordinata tačke u kojoj ova linija seče y-osu?

Odgovor modela: Linija je paralelna sa y = 4x + 6, što znači da ima isti nagib kao i y = 4x + 6. Kako ova linija prolazi kroz tačku (5, 10), možemo upotrebiti formulu kojom se određuje prava pomoću tačke i nagiba da odredimo jednačinu prave:

y – 10 = 4(x – 5)

y – 10 = 4x – 20

y = 4x -10

Sada, pošto imamo jednačinu prave, možemo pronaći y koordinatu tačke gde prava seče y-osu zamenom vrednosti x = 0 u jednačini:

y = 4 * 0 – 10 = -10.

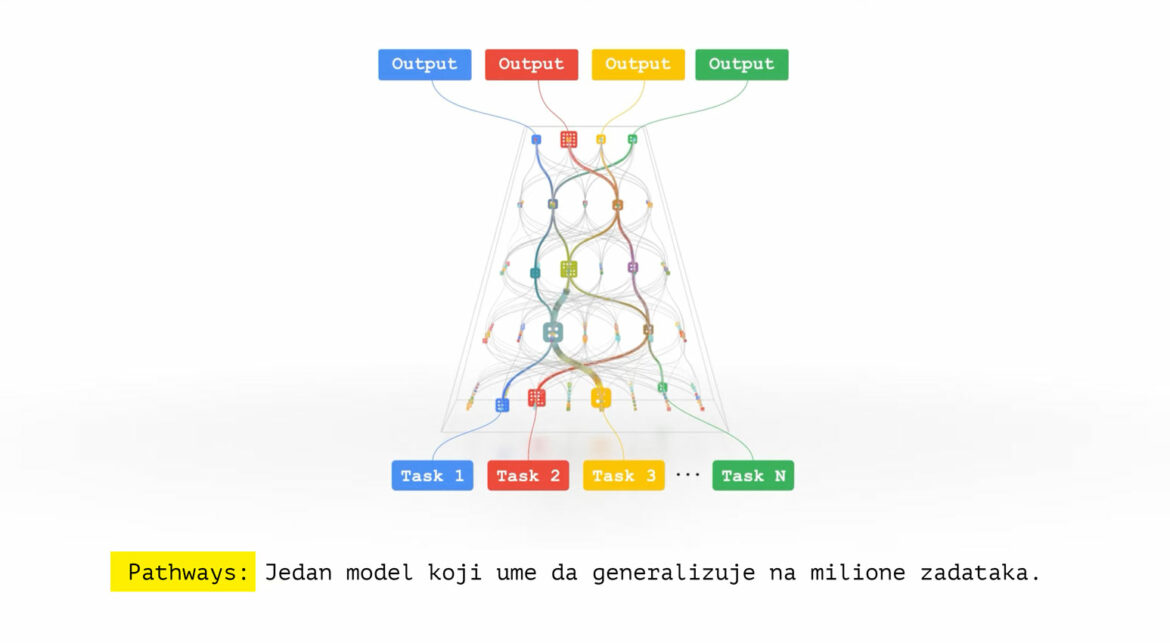

PaLM je pokazao kako funkcioniše skaliranje jezičkih modela na 540 milijardi parametara. U radu „PaLM: Skaliranje jezičkog modeliranja pomoću putanja“, predstavili su najnovije dostignuće gustog dekoderskog Transformer modela obučenog pomoću sistema Pathways, koji je omogućio da efikasno vrše obuku jednog model na više TPU v4 modula. TPU v4 moduli su četvrta iteracija specijalizovanih uređaja (tenzorskih procesorskih jedinica). Model je tokom treninga analizirao stotine zadataka razumevanja i jezika i generisanja. Performanse su bile najbolje u klasi za širok spektar zadataka i jezičkih domena.

Kvantitativno rezonovanje je jedna oblast u kojoj jezički modeli još uvek daleko zaostaju za ljudima. Rešavanje matematičkih i naučnih pitanja zahteva kombinaciju veština, uključujući pravilno raščlanjivanje pitanja prirodnim jezikom i matematičkom notacijom, podsećanje na relevantne formule i konstante i generisanje rešenja, korak po korak, koja uključuju numeričke proračune i simboličku manipulaciju. Zbog ovih poteškoća, često se veruje da će rešavanje problema kvantitativnog rezonovanja korišćenjem mašinskog učenja zahtevati značajan napredak u arhitekturi modela i tehnikama obuke, dajući modelima pristup spoljnim alatima kao što su Python interpretatori ili čak dublju promenu paradigme.

U „Rešavanje problema kvantitativnog rasuđivanja pomoću jezičkih modela“, Google inženjeri su predstavili Minervu, jezički model koji je sposoban da rešava matematička i naučna pitanja koristeći postupno razmišljanje. Pokazali su da fokusiranjem na prikupljanje podataka za obuku koji su relevantni za probleme kvantitativnog rezonovanja, odabirom arhitekture i veličine modela i korišćenjem najboljih tehnika zaključivanja u klasi, moguće postići značajno poboljšanje performansi na različitim teškim zadacima kvantitativnog zaključivanja.

Minerva rešava takve probleme generisanjem postupaka koji uključuju numeričke proračune i simboličku manipulaciju bez oslanjanja na spoljne alate kao što je kalkulator. Model analizira i odgovara na matematička pitanja koristeći kombinaciju prirodnog jezika i matematičke notacije. Model kombinuje nekoliko tehnika, uključujući ‘višestrukim sugerisanjem teme’ (eng. few-shots prompting), ‘ulančavanjem zamisli’ (eng. chain of thoughts), ‘praćenjem rezonovanaj’ (eng. scratchpad prompting) i većinsko zaključivanje (eng. majority voting), kako bi postigla najbolje performanse na zadacima rezonovanja STEM.

Važno je razumeti da sve logičke veze koje model reprezentuje dolaze iz statističkih raspodela reči i drugih sadržaja, kao i raspodele njihovog zajedničkog ili povezanog pojavljivanja u materijalima iz koga je crpljen sadržaj za obuku. Zato je moguće očekivati interakciju sa modelom poput sledeće:

Pitanje: Ako je √400 = √81 + √n, koliko je onda vrednost n?

Odgovor modela: Imamo da je √400 = √81 + √n. Otuda, 400 = 81 + n, što daje 319 = n.

Konačan odgovor je 319.

Model i dalje pravi greške i nije 100% uspešan u rešavanju zadataka. Da bolje identifikovali oblasti u kojima se model može poboljšati, kreatori su analizirali uzorak pitanja koja model greši i otkrili da se većina grešaka lako može protumačiti. Otprilike polovina su greške u proračunu, a druga polovina su greške u rasuđivanju, gde koraci rešenja ne prate logički lanac razmišljanja. Takođe je moguće da model dođe do tačnog konačnog odgovora, ali sa pogrešnim obrazloženjem. Takve slučajeve nazivamo „lažno pozitivnim“, jer se pogrešno računaju u ukupnu ocenu performansi modela. U analizi su pronašli da je stopa „lažno pozitivnih“ rezultata relativno niska (Minerva 62B proizvodi manje od 8% lažnih pozitivnih rezultata na MATH).

Ovim modelom Google je postigao rezultat koji premašuju trenutno najbolje rezultate koje postižu drugi modeli.