Veštačka inteligencija (AI) postaje sveprisutna, ali njeni visoki računski i energetski zahtevi čine je skupom i nepristupačnom. Tim istraživača sa Univerziteta Rice razvija nove tehnike za optimizaciju velikih jezičkih modela (LLM), čime bi AI postala dostupnija i energetski efikasnija.

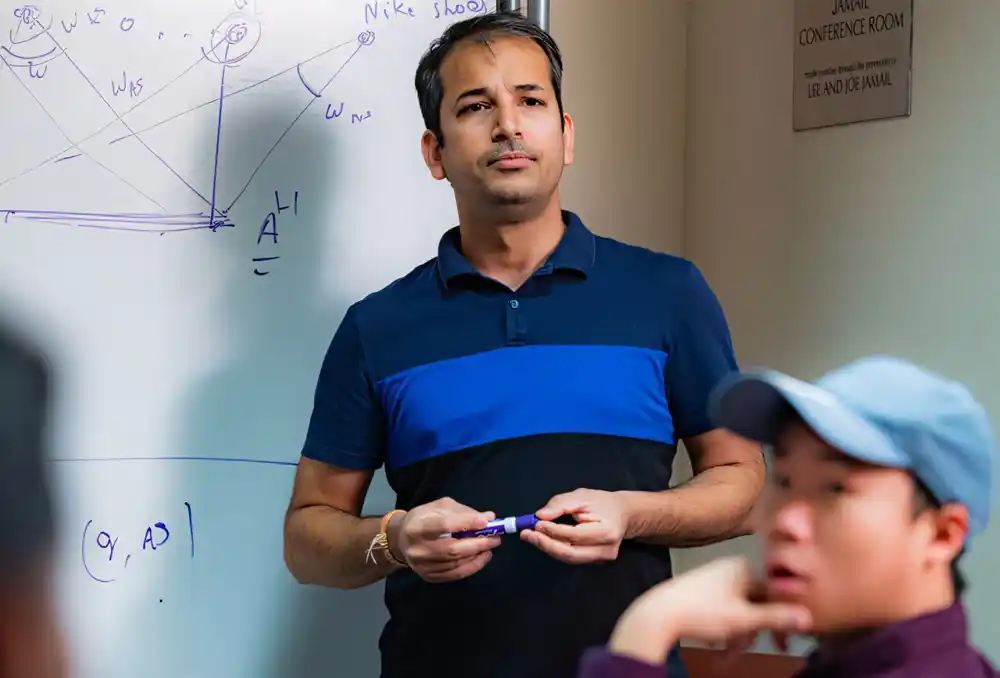

Profesor Anshumali ShriVastava ističe da je ključno omogućiti kompanijama i organizacijama da koriste AI na siguran i specijalizovan način. Međutim, obuka LLM-a od nule zahteva ogromne resurse, pa je prilagođavanje postojećih modela trenutno najpraktičnija opcija.

Na nedavnoj konferenciji NeurIPS 2024, istraživački tim predstavio je tri inovativna pristupa za poboljšanje AI modela:

- Podešavanje deljenja parametara – metoda koja smanjuje memorijske i računske zahteve modela, istovremeno održavajući njihovu preciznost. Ova tehnika ubrzava obradu AI modela za 11% bez dodatnog fino podešavanja.

- Pokretanje AI na CPU-ovima umesto GPU-ova – algoritam koji omogućava LLM-ima da rade na standardnim procesorima, smanjujući potrebu za skupim hardverom.

- Skalirana kvantizacija memorije – tehnika koja smanjuje količinu memorije potrebne za skladištenje konteksta u razgovorima, čime se optimizuje rad modela bez gubitka kvaliteta odgovora.

Ovi napreci mogu značiti da će u budućnosti AI alati raditi direktno na mobilnim uređajima i računarima, bez oslanjanja na skupe data centre. ShriVastava naglašava da AI mora postati efikasnija kako bi mogla rešavati globalne izazove, poput problema u zdravstvu i zaštiti životne sredine.