Tehniku je razvila CSIRO, nacionalna naučna agencija Australije, u saradnji sa Centrom za istraživanje kibernetičke bezbednosti i Univerzitetom u Čikagu. Metoda suptilno menja sadržaj kako bi ga učinila nečitljivim za AI modele, dok ljudsko oko ne primećuje razliku.

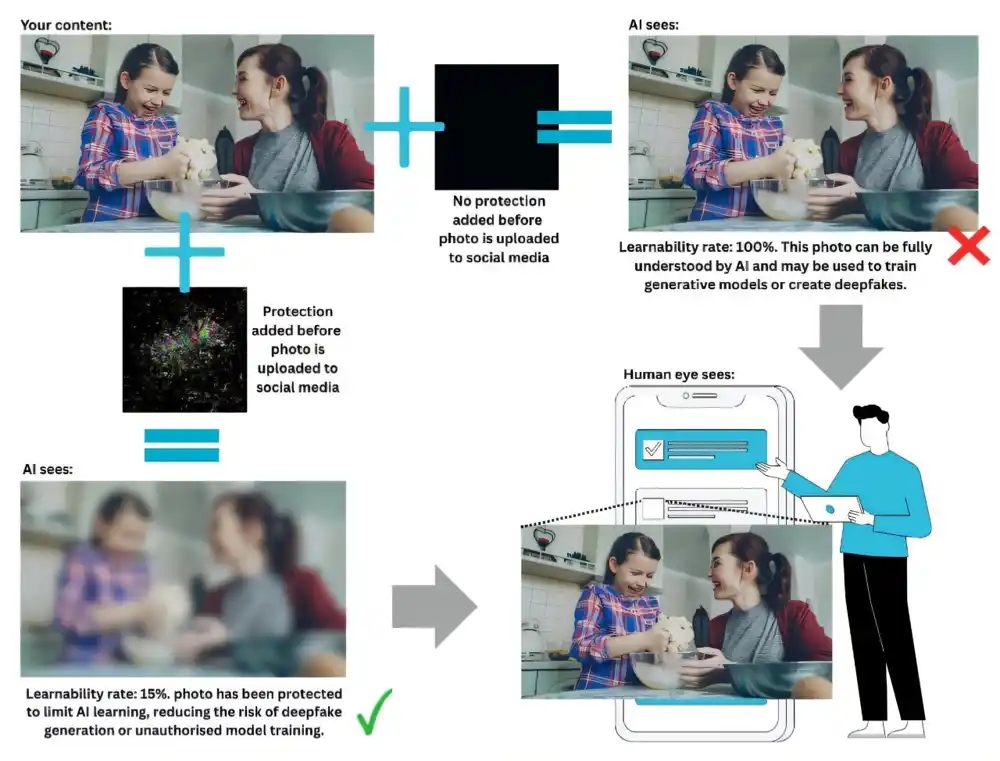

Ova inovacija može pomoći umetnicima, organizacijama i korisnicima društvenih mreža da zaštite svoje radove od korišćenja za obuku AI sistema ili kreiranje deepfake sadržaja. Na primer, korisnici društvenih mreža mogli bi automatski primeniti zaštitni sloj na svoje fotografije pre objavljivanja, čime bi sprečili AI sisteme da uče o njihovim facialnim karakteristikama.

Tehnika postavlja granicu onome što AI sistem može naučiti iz zaštićenog sadržaja. Ona pruža matematičku garanciju da ova zaštita važi čak i protiv adaptivnih napada ili pokušaja ponovnog obučavanja.

Dr. Derui Wang, naučnik iz CSIRO-a, istakao je da ova tehnika nudi novi nivo sigurnosti za sve koji postavljaju sadržaj na mrežu. „Postojeće metode oslanjaju se na pokušaje i greške ili pretpostavke o ponašanju AI modela,“ rekao je dr. Wang. „Naš pristup je drugačiji; možemo matematički garantovati da neovlašćeni modeli mašinskog učenja ne mogu učiti iz sadržaja iznad određenog praga.“

Dr. Wang je dodao da se tehnika može automatski primeniti na velikoj skali. „Društvena mreža ili veb sajt mogli bi ugraditi ovaj zaštitni sloj u svaku sliku koja se postavlja,“ rekao je. „To bi moglo smanjiti porast deepfake sadržaja, smanjiti krađu intelektualne svojine i pomoći korisnicima da zadrže kontrolu nad svojim sadržajem.“

Iako je metoda trenutno primenljiva na slike, postoje planovi da se proširi na tekst, muziku i video. Metoda je još uvek teoretska, a rezultati su potvrđeni u kontrolisanim laboratorijskim uslovima. Kod je dostupan na GitHub-u za akademsku upotrebu, a tim traži istraživačke partnere iz sektora kao što su bezbednost AI, etika, odbrana i kibernetička bezbednost.

Rad pod nazivom „Provably Unlearnable Data Examples“ predstavljen je na Simpozijumu o bezbednosti mrežnih i distribuiranih sistema (NDSS 2025), gde je dobio nagradu za istaknuti rad.