Sa dezinformacijama i dezinformacijama koje se šire na mreži, mnogi će možda poželeti jednostavan, pouzdan, automatizovan sistem za otkrivanje „lažnih vesti“ kako bi se lako identifikovale neistine od istine. Često uz pomoć mašinskog učenja, mnogi naučnici su razvili takve alate, ali stručnjaci savetuju oprez kada ih primenjuju.

U novom istraživanju, doktorka Dorit Nevo sa Politehničkog instituta Rensselaer, profesorka na Lalli School of Management, i kolege istraživali su greške koje ovi alati za otkrivanje prave. Otkrili su da su pristrasnost i generalizacija izazovi zbog obuke i dizajna modela, zajedno sa nepredvidljivošću sadržaja vesti. Izazovi izazivaju etičku zabrinutost.

Nevu su se u istraživanju pridružili Benjamin D. Horne, dr Benjamin D. Horne, docent za nauku o podacima i inženjering na Školi informacionih nauka Univerziteta Tennessee, i Susan L. Smith, Ph.D., viši predavač u Rensselaeru.

„Modeli se rangiraju na osnovu metrike performansi i objavljuju se samo istraživanja o modelu sa najboljim performansama“, kažu autori. „Ovaj format žrtvuje empirijsku strogost i ne uzima u obzir kontekst primene.“ Na primer, model može smatrati jedan izvor pouzdanim ili istinitim, kada izvor može u stvari da objavi mešavinu istinitih i lažnih vesti, u zavisnosti od teme.

Povrh toga, skup oznaka koji se naziva temeljna istina koristi se za obuku i procenu modela, a ljudi koji generišu oznake mogu i sami biti nesigurni da li je vest stvarna ili lažna.

Zajedno, ovi elementi mogu održavati predrasude.

„Jedan potrošač može da vidi sadržaj kao pristrasan za koji drugi misli da je istinit“, rekao je Nevo. „Slično, jedan model može označiti sadržaj kao nepouzdan, a drugi neće. Programer može smatrati jedan model najboljim, ali drugi programer se može ne složiti. Mislimo da se mora postići jasno razumevanje ovih pitanja pre nego što se model može smatrati pouzdanim.“

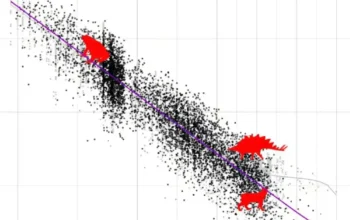

Istraživački tim je analizirao 140.000 novinskih članaka iz jednog meseca u 2021. i ispitao probleme koji proizilaze iz automatizovanog moderiranja sadržaja. Došli su do tri glavna zaključka. Prvo, važno je ko bira osnovnu istinu. Drugo, operacionalizacija zadataka za automatizaciju može produžiti pristrasnost. Treće, ignorisanje ili pojednostavljivanje konteksta aplikacije smanjuje validnost istraživanja.

„Ključno je angažovati različite programere prilikom utvrđivanja temeljne istine“, rekao je Horne. „Na tom zadatku treba da angažujemo ne samo programere i analitičare podataka, već i stručnjake iz drugih oblasti kao i pripadnike šire javnosti.

Smit dodaje: „Modeli imaju dalekosežne društvene, ekonomske i etičke implikacije koje se ne mogu razumeti samo u jednoj oblasti.“

Dalje, model se mora stalno iznova procenjivati. Vremenom, modeli možda neće uspeti da rade kako je predviđeno i osnovna istina može postati neizvesna. Kako se anomalije povećavaju, stručnjaci moraju istražiti nove pristupe za utvrđivanje temeljne istine. Slično tome, metode za utvrđivanje temeljne istine će se razvijati kako nauka bude napredovala, kao i naši modeli.

Konačno, moramo razumeti ozbiljne implikacije koje bi imalo netačno otkrivanje lažnih vesti i uzeti u obzir da jedan model možda nikada neće predstavljati rešenje koje odgovara svima. Možda bi medijska pismenost u kombinaciji sa predlozima modela pružila najveću pouzdanost, ili bi model trebalo primeniti samo na jednu temu vesti, a ne na sve.

„Kombinovanjem slabih, ograničenih rešenja, možda ćemo moći da stvorimo jaka, robusna, pravedna i sigurna rešenja“, zaključuju istraživači.

„U ovom trenutku u istoriji, sa sve većim širenjem dezinformacija i polarizacijom društva, ulozi ne mogu biti veći za razvoj tačnih alata za otkrivanje lažnih vesti. Jasno je da moramo da nastavimo sa oprezom, inkluzivnošću, pažljivošću i transparentnošću“, rekao je Chanaka Edirisinghe, dr., vršilac dužnosti dekana Rensselaer’s Lalli School of Management.